NEWS | テクノロジー

2020.05.07 14:00

かつてアインシュタインは、「本当に価値のあるものは直感だ」と語ったそうだ。この直感性は意図やコミュニケーションを理解するうえでもっとも重要なもののひとつだが、とりわけ機械には備わっていない。

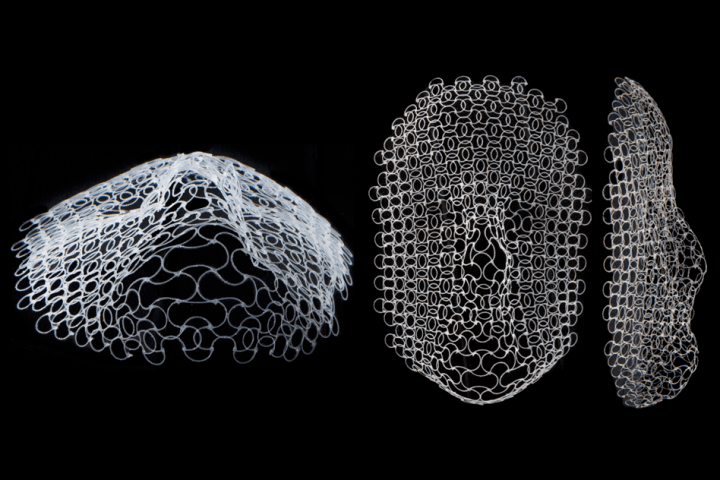

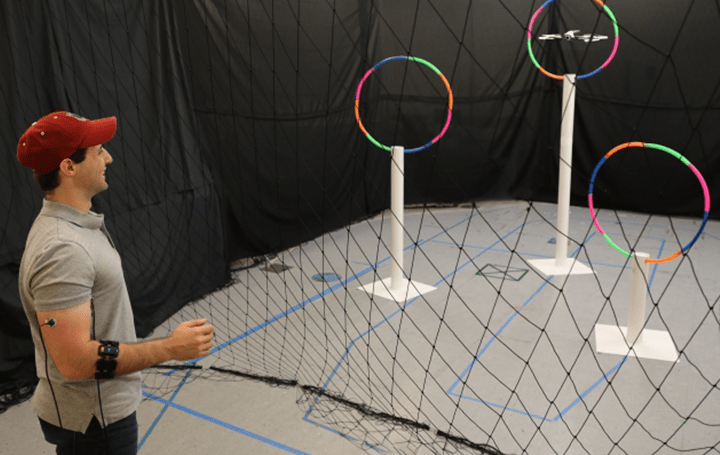

こうした課題にMITコンピュータ科学・人工知能研究所の研究グループが取り組んだ。人間とロボットのあいだでよりシームレスな操作を目指して、人間の筋肉の電気信号を使い、ウェアラブルセンサーを通じてドローンを操縦する「Conduct-A-Bot」というシステムを開発したのだ。

このシステムでは、上腕二頭筋、上腕三頭筋、前腕部に筋電位計測装置とモーションセンサーを装着し、腕を動かしたときの筋肉の電気信号と動作を測定。この信号をアルゴリズムが処理して、身振りをリアルタイムで検出。オフラインでの調整やユーザーのトレーニングデータは不要で、周囲の環境に影響を及ぼすこともない。

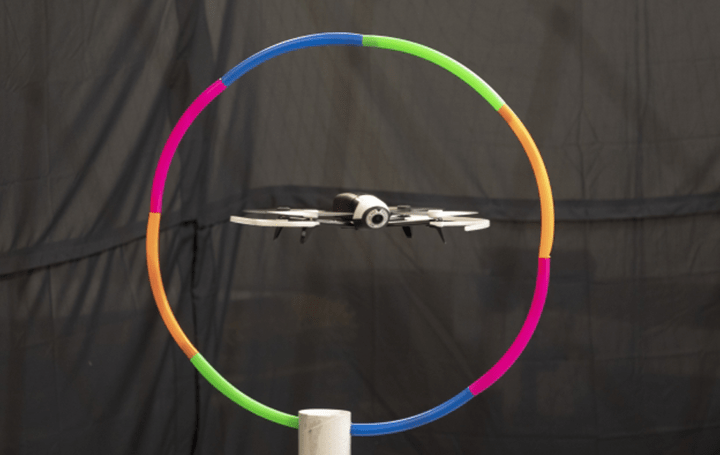

身振りとしては、腕をしっかりと固定した状態で前腕を回転させたり、握りこぶしを動かしたりといったアクションのみ。これだけでドローンを上下左右に移動させたり、前進、回転、静止といった操縦ができる。

実験では、ドローンがリングを通過するように1,500回以上の身振りを行い、82%が成功。また、ドローンがコントロールされていない状態でも、合図した身振りの約94%を正しく認識したそうだ。

将来的には、遠隔探査、支援用パーソナルロボット、モノを運んだり持ち上げたりといった製造工程など、さまざまな応用の可能性があるとしている。さらに、ソーシャル・ディスタンスに配慮して、病室の清掃や医薬品の運搬など、非接触での作業の可能性も広がるかもしれない。![]()